14 grudnia podczas obchodów Chanuki na plaży Bondi w Syndey doszło do zamachu terrorystycznego, w wyniku którego zginęło 15 osób oraz jeden ze sprawców. Zraniony został m.in. Arsen Ostrovsky, prawnik zajmujący się prawami człowieka, który wraz z rodziną przeprowadził się w ostatnim czasie z Izraela do Australii. W sieci pojawiły się narracje, jakoby zamach był operacją fałszywej flagi. Dezinformacja ta oparta jest o fałszywe zdjęcie wygenerowane za pomocą sztucznej inteligencji. W artykule wyjaśniamy, dlaczego nie możemy polegać bezwarunkowo na serwisach wykrywających manipulacje AI.

Zdjęcie wygenerowane przez AI

Ocena przez detektory AI

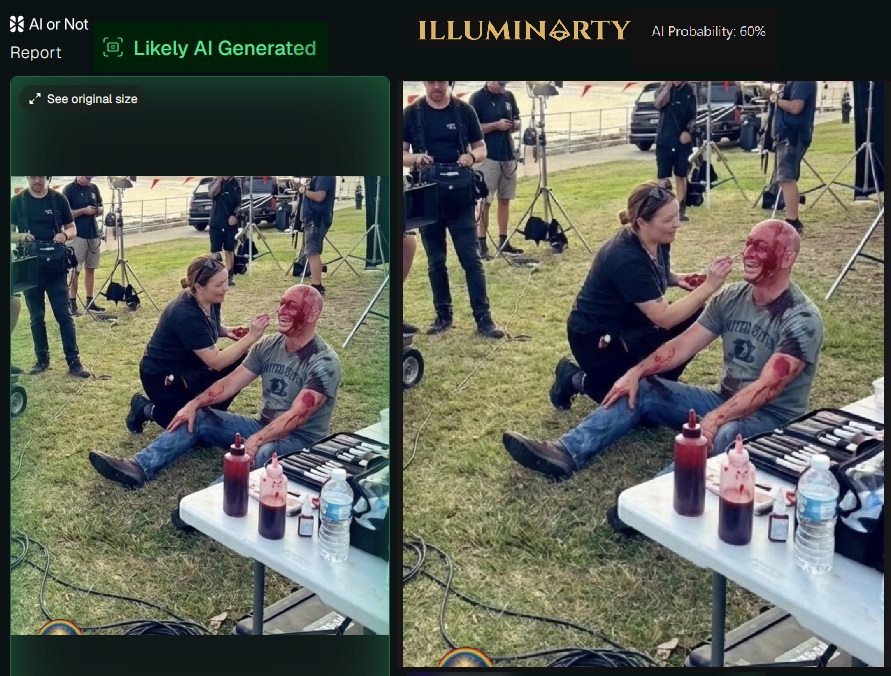

Głównym argumentem osób szerzących dezinformację na temat zamachu w Sydney była analiza pochodząca z serwisów wykrywających ingerencję sztucznej inteligencji w obrazy. Rzeczywiście, obie aplikacje (Hive oraz WasItAI) wykazały zerowe prawdopodobieństwo, że zdjęcie przedstawiane w mediach społecznościowych stworzono za pomocą AI. Jednakże nie wszystkie dostępne serwisy były tak jednoznaczne w ocenie prawdziwości omawianej fotografii.

Niektóre serwisy weryfikujące ingerencję sztucznej inteligencji w obrazy były bliższe prawdy. AI or Not wskazało, że zdjęcie z izraelskim prawnikiem wygenerowano prawdopodobnie za pomocą sztucznej inteligencji, a Illuminarty oceniło taką możliwość na 60%. Dlatego można przypuszczać, że wybór narzędzi, które potwierdzały dezinformację, nie był przypadkowy. Zastosowano tu technikę manipulacji znaną jako cherry-picking, czyli selektywnie dobrano tylko te aplikacje, które popierały teorię o rzekomej operacji fałszywej flagi.

Dlaczego detektory AI nie działają?

Dlaczego niektóre detektory zdjęć nieprawidłowo oceniają, czy dany obraz stworzono za pomocą AI? Przede wszystkim tego typu serwisy zawsze będą o krok za narzędziami do tworzenia sztucznych treści. Ben Y. Zhao, profesor informatyki na Uniwersytecie Chicagowskim, zauważa, że do zwiększenia skuteczności tych narzędzi potrzeba dużego zasobu danych treningowych, co z kolei jest czasochłonne i kosztowne.

Istnieją również sposoby na utrudnienie pracy detektorom AI. Wystarczy, że autor dezinformacji wprowadzi do wygenerowanego obrazu szumy, lekkie rozmycia lub wyedytuje obraz, kompresując go, obracając albo przycinając, a zastosowanie takich zabiegów może doprowadzić do zmylenia detektorów.

W jaki sposób zweryfikować, czy dane zdjęcie stworzono za pomocą AI? Na początek postarajmy się znaleźć źródło oryginalnej fotografii i ocenić jego wiarygodność. Warto sprawdzić, czy istnieje inne ujęcie danej sceny. Jeżeli nasz obraz to jedyna dokumentacja ważnego zdarzenia, można przypuszczać, że nie jest on prawdziwy. Najważniejsze jednak, aby zawsze przyglądać się uważnie zdjęciom wzbudzającym duże emocje w mediach społecznościowych, gdyż artefakty AI bardzo często są widoczne gołym okiem.

Podsumowanie

W wyniku zamachu na plaży w Sydney zginęło 15 osób oraz jeden z zamachowców. Zdjęcie przedstawiające rzekomo Arsena Ostrovsky’ego na planie filmowym stworzono za pomocą sztucznej inteligencji. Dobór detektorów, które nie wykryły ingerencji AI w tej fotografii, nie był przypadkowy. Skuteczność tego typu serwisów zależy od wielu czynników, dlatego powinny być one traktowane jako pomocnicze narzędzie w weryfikacji prawdziwości danego obrazu.

Źródła

Euronews: Australia. Strzelanina na plaży Bondi: co wiemy do tej pory

BBC: Fake AI image used to claim Bondi Beach shooting was staged

9news: ’An absolute massacre’: Man injured in Bondi Beach shooting tells of chaos

CNN: Do AI image detectors work? We tested 5 | Visual investigations

Adversarial Robustness of AI-Generated Image Detectors in the Real World

Navigating the Challenges of AI-Generated Image Detection in the Wild: What Truly Matters?

Fake or JPEG? Revealing Common Biases in Generated Image Detection Datasets